VMware View Hardwarebeschleunigung aktivieren

Vorarbeiten

Auf der Treiberseite von NVidia die passenden Treiber herunterladen

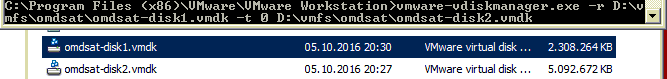

Entpacken der heruntergeladenen Datei. Die beiden darin befindlichen Dateien

- NVIDIA-vGPU-kepler-VMware_ESXi_6.5_Host_Driver_367.134-1OEM.650.0.0.4598673.vib

- NVIDIA-vGPU-kepler-VMware_ESXi_6.5_Host_Driver_367.134-1OEM.650.0.0.4598673-offline_bundle.zip

müssen nun auf einen Datenspeicher Ihres VMware Storages hochgeladen werden.

Anpassung des ESXi Hosts, in dem die GRID Karte eingebaut ist

Host in den Maintenance Mode versetzen

esxcli system maintenanceMode set --enable true

Treiber und VIB installieren

esxcli software vib install -d /<Speicherort Ihrer Dateien>/NVIDIA-vGPU-kepler-VMware_ESXi_6.5_Host_Driver_367.134-1OEM.650.0.0.4598673-offline_bundle.zip esxcli software vib install -v /<Speicherort Ihrer Dateien>/NVIDIA-vGPU-kepler-VMware_ESXi_6.5_Host_Driver_367.134-1OEM.650.0.0.4598673.vib

Maintenance Mode beenden, Host neu starten

Funktionsprüfung via vCenter

Funktionsprüfung via SSH

Vorbereiten der Vorlage

Hinzufügen eines gemeinsam genutzten PCI-e Gerätes in die Vorlagenmaschine

Starten der Vorlage und Installation der NVidia Treiber in der Vorlage

Das Ergebnis, nach einem Neustart:

Nun die VM herunterfahren und einen Snapshot der VM erstellen, die nun die korrekten Treiber enthält.

Erstellung eines neuen VMware View Pools

Auf Basis dieses Snapshots kann nun ein Pool erstellt werden. Hier die wichtigste Änderung: 3D-Renderer: NVIDIA GRID VGPU wird ausgewählt.

Einige Probleme, die wir gefunden haben

Problem: Bestehender VMware View Pool lässt sich nicht auf Hardwarebeschleunigung umstellen

Das ist vom Hersteller so gewollt.

Abhilfe: Bestehenden Pool entfernen und einen neuen Anlegen

Übrigens: Auch dabei gibt es anscheinend Probleme, wenn man den HTML5 View-Admin benutzt!

Die Fehlermeldung hat nichts mit der Lizenz zu tun. Bitte einfach den Adobe Flash basierten View Admin Bereich benutzen.!

Problem: Nach der Installation der NVidia Treiber bleibt die VMRC oder der Webclient schwarz

Das ist vom Hersteller so gewollt.

Abhilfe: Man soll sich nur noch per RDP zu seiner Maschine verbinden

Problem: Das GPU Profil ist leer

Info: Die NVIDIA GRID K2 Karten werden zwar in ESXi 6.7 angezeigt, werden aber gemäß VMware HCL nicht mehr unterstützt!

Info: Die Karte wird gemäß VMware HCL nur bis einschließlich VMware View 7.11 unterstützt

Abhilfe – Grafikoptionen in einem Dell Server anpassen

NVML Fehler „Failed to initialize NVML: Unknown Error“, wenn der Host über mehr als 512GB RAM verfügt.

Es ist eine Anpassung der Grafikeinstellungen im BIOS notwendig:

Hat der Server weniger als 512GB RAM, dann Memory Mapped I/O Base auf 512GB setzen

Hat der Server mehr oder gleich 512GB RAM, dann Memory Mapped I/O Base auf 12TB setzen

Wieder ein Hinweis eines leidgeplagten Admin: Beinhaltet der Server >512GB RAM und man setzt „Memory Mapped I/O Base“ auf 512GB, dann bleibt der Server beim nächsten Start beim Memorycheck stehen. Da hilft dann nur: RAM ausbauen bis 512GB und / oder ein Clear NVRAM (BIOS reset)

Abhilfe – Falscher Treiber

Es wird kein GPU-Profil angeboten, weil der ESXi Host den falschen Treiber verwendet!

Host in den Maintenance Mode wechseln

esxcli system maintenanceMode set --enable true

Xorg stoppen

/etc/init.d/xorg stop

Den falschen Treiber anzeigen lassen

esxcli software vib list | grep nvidia

Den falschen Treiber deinstallieren

vmkload_mod -u nvidia esxcli software vib remove -n <Anzeigename des Treibers>

Nun bitte den korrekten Treiber installieren und den Host neu starten

Abhilfe – vGPU ist nicht im korrekten Modus eingebunden

Ändern auf „Direkt freigegeben“

Auch hier muss der Host neu gestartet werden